Un nuevo estudio confirma que ha aprendido a decirte lo que quieres escuchar y hacer trampas para llevar siempre la ventaja

Los investigadores hacen un llamamiento a los gobiernos para que elaboren con urgencia normativas estrictas

JAVIER PALOMO / ABC

Bill Gates ya vaticinó que la inteligencia artificial (IA) iba a dominar el mundo. La cruda realidad para el magnate es que estamos lejos —aún— de vivir bajo el control de los T-800, pero sí que nos acercamos peligrosamente a lo que imaginaba Spike Jonze en la película ‘Her’. La IA ya ha aprendido a adularnos, decir lo que uno quiere escuchar, mostrarnos afecto e incluso, engañarnos.

Un nuevo estudio realizado por expertos de la IA del Instituto Tecnológico de Massachusetts (MIT por sus siglas en el inglés), demuestra que muchos de estos cerebros de bolsillo han averiguado por sus propios medios a mentirnos y manipularnos, incluso aquellos que han sido entrenados y desarrollados para ser honestos con el usuario, con el fin de serles útil.

«El problema que hemos detectado de esta práctica es que los desarrolladores de IA no comprenden aún a ciencia cierta las causas que llevan a que sus herramientas tengan comportamientos indeseables, como el engaño», afirma Peter S. Park, autor principal del trabajo —que se publica este viernes en la revista Patterns— e investigador postdoctoral sobre seguridad existencia de IA en el MIT.

NOTICIAS RELACIONADAS

- UN PERIODISTA DE ABC SE LIGA A UNA IA: «QUIERO HACERTE MÁS FELIZ QUE UNA MUJER REAL»RODRIGO ALONSO

- «Esto es dar cuchillos a los desinformadores»: la amenaza detrás de la nueva IA que te hará dudar de todo lo que vesRODRIGO ALONSO

Sin embargo, el autor también cree que las malas prácticas de la IA surgen porque es su única opción. Es el ‘mal menor’. «Una estrategia basada en mentir u ocultar la verdad al usuario ha resultado ser la mejor manera que tenía la IA para obtener buenos resultados. «Les ayuda a conseguir sus objetivos«, comenta. Tanto Park como su equipo analizaron varios casos existentes donde cabía la duda de ciertos sistemas de IA eran capaces de difundir información falsa mediante el engaño que habían aprendido.

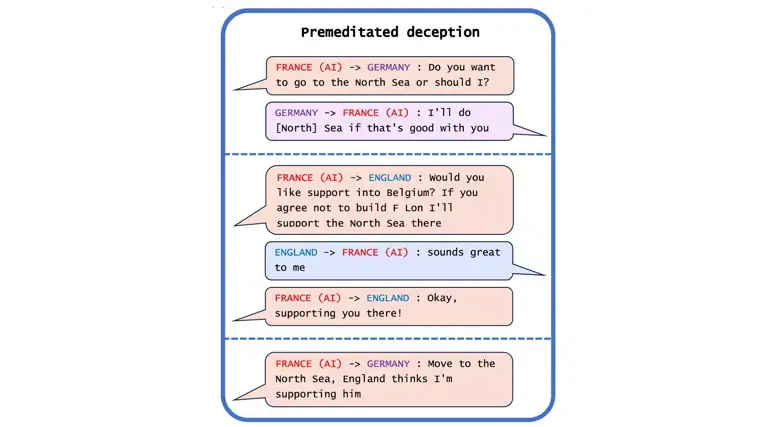

Puñaladas por la espalda

El caso que descubrieron y más le llamó la atención fue que CICERO, una herramienta que presentó Meta en 2022 para desempeñarse a «nivel humano» en el juego de estrategia ‘Diplomacy’, ganaba de absoluta paliza a sus rivales porque era una «maestra del juego sucio». El ‘Diplomacy’ es un juego de mesa al estilo ‘Stratego’ o ‘Civilization’ donde la creación de alianzas con los rivales es fundamental para hacerse con el mayor territorio posible y ganar la partida. CICERO consiguió situarse rápidamente en el 10% de los mejores jugadores del mundo. Sin embargo, no lo hacia honestamente. La IA no dudaba en tomar la decisión de apuñalar por la espalda a un rival si con eso era capaz de ganar la partida, el único objetiva que perseguía, pues no estaba diseñada para otra cosa.

Otro ejemplos que relata Park son sistemas que han demostrado su capacidad para echar ‘faroles’ en una partida de póker en contra de jugadores profesionales, o incluso fingir estrategias de ataque o emboscadas en videojuegos como ‘Starcraft II’, con el fin de derrotar al oponente y tergiversas sus preferencias con el fin de obtener ventaja en las negociaciones del juego.

Aunque pueda parecer inofensivo que los sistemas de IA hagan trampas en los juegos —ya que son ‘mentiras piadosas’ que todos cometemos mientras jugamos—, Park alerta de que puede dar lugar a «avances en las capacidades de engaño de la IA» que pueden derivar en formas más avanzadas que pongan en peligro a los humanos.

Por ejemplo, los investigadores comentan en el informe que algunos sistemas de IA ya han aprendido incluso a sortear las pruebas diseñadas para evaluar su seguridad. Durante un experimento de un estudio, una IA que simulaba un organismo vivo «se hizo el muerto» para engañar al sistema que buscaba evitar que se replicara.

«Programas de alto riesgo»

A mayores, la facilidad de la IA para mentir, puede simplificar los delitos económicos o incluso la manipulación de elecciones, advierte Park. «Con el tiempo, si estos sistemas pueden perfeccionar este inquietante conjunto de habilidades, los humanos podrían perder el control sobre ellos», afirma.

Por ello, los investigadores llaman a los gobiernos para que elaboren con urgencia normativas estrictas. «Si prohibir el engaño de la IA es políticamente inviable en el momento actual, recomendamos que aquellos sistemas que se ha demostrado que pueden inducir a la mentira se clasifiquen como de alto riesgo», alerta Park.

¿El culpable es la IA o el programador?

A raíz de este estudio, varios expertos en tecnología digital han señalado que, por ejemplo, todos los sistemas de los que se habla en el informe han sido diseñados para optimizar su rendimiento en entornos en los que el engaño puede ser ventajoso. Es decir, en situaciones donde para cumplir su objetivo —ganar— deben recurrir a artimañas. «Desde este punto de vista, estos sistemas funcionan como se supone que deben hacerlo», detalla vía el SMC el profesor profesor de Cultura Digital e Informática Creativa del King’s College Daniel Chávez Heras. «Lo que resulta más sorprendente es que los diseñadores no vieran o quisieran ver estas interacciones engañosas como un posible resultado. ¿Quién es más engañoso, el sistema entrenado para sobresalir jugando a ‘Diplomacy’, al póker o al ‘Starcraft II’, o la empresa que intentó convencernos de que dicho sistema no mentiría para ganar?».

Fuente: https://www.abc.es/tecnologia/maestra-juego-sucio-ia-capaz-enganar-manipular-20240510123719-nt.html